نحوهی کارکرد واقعی ChatGPT و اینکه چرا اینقدر متحول کننده بوده است

در اواخر سال ۲۰۲۲، قبل از اینکه چتباتهای هوش مصنوعی به طور گسترده ظاهر شوند ابزارهایی مانند گوگل و ولفرام آلفا از طریق یک فیلد ورودی متن تکخطی با کاربران تعامل داشتند و نتایج متنی ارائه میدادند. گوگل نتایج جستجو شامل فهرستی از صفحات وب و مقالاتی که اطلاعات مربوط به جستجوها در آن بود را برمیگرداند و ولفرام آلفا عموماً پاسخهایی ارائه میداد که ریاضی و مرتبط با تحلیل دادهها بودند.

در اواخر سال ۲۰۲۲، قبل از اینکه چتباتهای هوش مصنوعی به طور گسترده ظاهر شوند ابزارهایی مانند گوگل و ولفرام آلفا از طریق یک فیلد ورودی متن تکخطی با کاربران تعامل داشتند و نتایج متنی ارائه میدادند. گوگل نتایج جستجو شامل فهرستی از صفحات وب و مقالاتی که اطلاعات مربوط به جستجوها در آن بود را برمیگرداند و ولفرام آلفا عموماً پاسخهایی ارائه میداد که ریاضی و مرتبط با تحلیل دادهها بودند.

در مقابل، ChatGPT پاسخی را بر اساس زمینه و هدف پشت سوال کاربر ارائه میدهد. البته گوگل حالت پاسخگویی خود را تغییر داده است. اکنون قبل از نتایج جستجو، پاسخهای مبتنی بر هوش مصنوعی ارائه میدهد و احتمالاً به این کار ادامه خواهد داد. از سوی دیگر، ولفرام آلفا از هوش مصنوعی در پشت صحنه برای کمک به محاسبات خود استفاده میکند اما پاسخهای مبتنی بر هوش مصنوعی ارائه نمیدهد.

اساساً، قدرت جستجوی گوگل در توانایی آن در انجام جستجوهای عظیم در پایگاه داده و ارائه مجموعهای از تطابقها است. قدرت ولفرام آلفا در توانایی آن در تجزیه سوالات مرتبط با دادهها و انجام محاسبات است.

قدرت ChatGPT و تقریباً هر چتبات هوش مصنوعی دیگری مانند Claude، Copilot، Perplexity و Google Gemini در توانایی تجزیه سوالات و تولید پاسخها و نتایج کاملاً دقیق بر اساس اکثر اطلاعات متنی دیجیتالی موجود در جهان است. برخی از چتباتها محدودیتهایی بر اساس زمان اسکن اطلاعات دارند، اما اکثر آنها اکنون میتوانند به اینترنت زنده دسترسی داشته باشند تا دادههای فعلی را در پاسخهای خود لحاظ کنند.

در این مقاله، خواهیم دید که ChatGPT چگونه میتواند با استفاده از فناوری به نام هوش مصنوعی مولد (Generative Artificial Intelligence)، پاسخهای کاملاً دقیق تولید کند. ما با نگاهی به مراحل اصلی عملکرد ChatGPT شروع خواهیم کرد، سپس برخی از اجزای اصلی معماری هوش مصنوعی را که باعث عملکرد آن میشوند، پوشش خواهیم داد.

دو مرحله اصلی عملیات ChatGPT

بیایید دوباره از جستجوی گوگل (که از هوش مصنوعی گوگل جمینی متمایز است) به عنوان یک قیاس استفاده کنیم. وقتی از جستجوی گوگل میخواهید چیزی را جستجو کند، احتمالاً میدانید که در لحظه درخواست شما، کل وب را برای یافتن پاسخ جستجو نمیکند. در عوض، گوگل پایگاه داده خود را برای یافتن صفحاتی که با آن درخواست مطابقت دارند، جستجو میکند. جستجوی گوگل دو مرحله اصلی دارد: مرحله خزش و جمعآوری دادهها، و مرحله تعامل یا جستجوی کاربر.

به طور کلی، ChatGPT و سایر چتباتهای هوش مصنوعی به یک شکل کار میکنند. مرحله جمعآوری دادهها پیشآموزش نامیده میشود، در حالی که مرحله پاسخگویی به کاربر به عنوان استنتاج شناخته میشود. جادوی پشت هوش مصنوعی مولد و دلیل گسترش آن این است که نحوه عملکرد پیشآموزش به طور چشمگیری مقیاسپذیر بوده است. این مقیاسپذیری با نوآوریهای اخیر در فناوری سختافزار مقرون به صرفه و محاسبات ابری امکانپذیر شده است.

نحوهی عملکرد پیشآموزش هوش مصنوعی

به طور کلی (زیرا پرداختن به جزئیات، حجم زیادی را به خود اختصاص میدهد)، هوش مصنوعی با استفاده از دو رویکرد اصلی پیشآموزش میدهد: تحت نظارت و بدون نظارت. اکثر پروژههای هوش مصنوعی تا زمان ظهور سیستمهای هوش مصنوعی مولد فعلی مانند ChatGPT از رویکرد تحت نظارت استفاده میکردند.

پیشآموزش تحت نظارت فرآیندی است که در آن یک مدل بر روی یک مجموعه دادهی برچسبگذاری شده آموزش داده میشود، که در آن هر ورودی با یک خروجی مربوطه مرتبط است.

به عنوان مثال، یک هوش مصنوعی میتواند بر روی یک مجموعه داده از مکالمات خدمات مشتری آموزش داده شود، که در آن سوالات و شکایات کاربر با پاسخهای مناسب از نماینده خدمات مشتری برچسبگذاری شده است. برای آموزش هوش مصنوعی، سوالاتی مانند "چگونه میتوانم رمز عبور خود را بازنشانی کنم؟" به عنوان ورودی کاربر ارائه میشود و پاسخهایی مانند "شما میتوانید با مراجعه به صفحه تنظیمات حساب در وبسایت ما و دنبال کردن دستورالعملها، رمز عبور خود را بازنشانی کنید" به عنوان خروجی ارائه میشود.

در یک رویکرد آموزش تحت نظارت، مدل کلی برای یادگیری یک تابع نگاشت آموزش داده میشود که میتواند ورودیها را به خروجیها به طور دقیق نگاشت کند. این فرآیند اغلب در وظایف یادگیری تحت نظارت، مانند طبقهبندی، رگرسیون و برچسبگذاری توالی استفاده میشود.

همانطور که ممکن است تصور کنید، محدودیتهایی در نحوه مقیاسپذیری این روش وجود دارد. مربیان انسانی باید در پیشبینی همه ورودیها و خروجیها بسیار پیش بروند. آموزش میتواند زمان بسیار زیادی طول بکشد و در تخصص موضوعی محدود باشد.

اما همانطور که متوجه شدهایم، ChatGPT محدودیتهای بسیار کمی در تخصص موضوعی دارد. میتوانید از آن بخواهید که برای شخصیت رئیس مایلز اوبرایان از پیشتازان فضا (در مجموعه علمی تخیلی پیشتازان فضا) رزومه بنویسد، فیزیک کوانتومی را توضیح دهد، یک قطعه کد بنویسد، یک داستان کوتاه تولید کند و سبکهای حکومتی روسای جمهور سابق ایالات متحده را مقایسه کند.

پیشبینی همه سوالاتی که ممکن است پرسیده شود غیرممکن است، بنابراین هیچ راهی وجود ندارد که ChatGPT بتواند با یک مدل تحت نظارت آموزش داده شود. در عوض، ChatGPT از پیشآموزش بدون نظارت استفاده میکند و این تغییر دهنده بازی است.

پیشآموزش بدون نظارت فرآیندی است که طی آن یک مدل بر روی دادههایی آموزش داده میشود که هیچ خروجی خاصی با هر ورودی مرتبط نیست. در عوض، مدل طوری آموزش داده میشود که ساختار و الگوهای زیربنایی در دادههای ورودی را بدون هیچ کاری در ذهن یاد بگیرد. این فرآیند اغلب در کارهای یادگیری بدون نظارت، مانند خوشهبندی، تشخیص ناهنجاری و کاهش ابعاد استفاده میشود. در مدلسازی زبان، پیشآموزش بدون نظارت میتواند یک مدل را برای درک نحو و معنای زبان طبیعی آموزش دهد تا مدل بتواند متن منسجم و معناداری را در یک زمینه محاورهای تولید کند.

اینجاست که دانش ظاهراً بیحد و حصر ChatGPT امکانپذیر میشود. از آنجا که توسعهدهندگان نیازی به دانستن خروجیهای ورودیها ندارند، تنها کاری که باید انجام دهند این است که اطلاعات بیشتر و بیشتری را در مکانیسم پیشآموزش ChatGPT، که مدلسازی زبان مبتنی بر مولد(Transformer) نامیده میشود، وارد کنند.

همچنین در اینجا، در جریان تزریق دادهها به هوش مصنوعی، سازندگان چتباتهای مدرن خود را در معرض مشکل یافتهاند. شرکتهای هوش مصنوعی، هوش مصنوعیهای خود را بدون اجازه، با اطلاعات دارای حق چاپ از شرکتهای دیگر آموزش میدهند.

این رویکرد آموزش جهانی، چتباتها را توانمندتر میکند. اما عارضه جانبی آن این است که آنها ترافیک را از شرکتها و نویسندگانی که محتوای اصلی را نوشتهاند، دور میکنند. انتظار داشته باشید که این جنبه از هوش مصنوعی مولد در سالهای آینده در دادگاهها مورد بحث قرار گیرد.

اما این مقاله در مورد فناوری است، بنابراین بیایید به سراغ یک فناوری کلیدی برویم که هوش مصنوعی مولد را ممکن میسازد.

معماری مولد

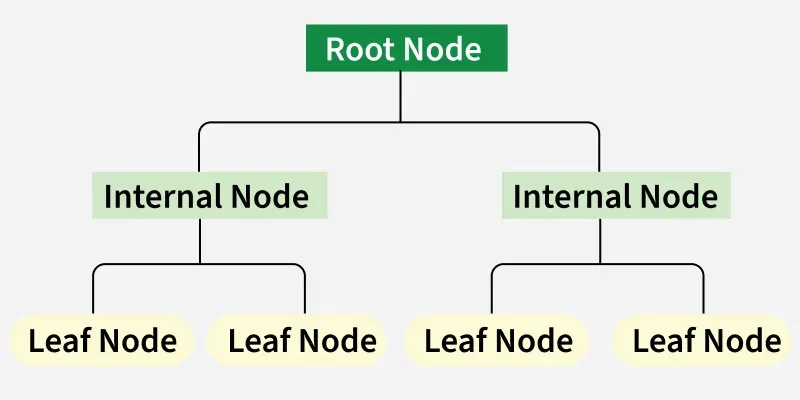

معماری مولد نوعی شبکه عصبی است که برای پردازش دادههای زبان طبیعی استفاده میشود. یک شبکه عصبی با پردازش اطلاعات از طریق لایههایی از گرههای به هم پیوسته، نحوه عملکرد مغز انسان را شبیهسازی میکند. میتوانید یک شبکه عصبی را مانند یک تیم هاکی در نظر بگیرید. هر بازیکن نقشی دارد، اما آنها توپ را بین بازیکنانی با موقعیتهای خاص رد و بدل میکنند و همه با هم برای کسب امتیاز تلاش میکنند.

معماری مولد توالی کلمات را با استفاده از "توجه به خود" پردازش میکند تا اهمیت کلمات مختلف را در یک توالی هنگام پیشبینی بسنجد. توجه به خود شبیه به این است که چگونه یک خواننده ممکن است به یک جمله یا پاراگراف قبلی متن برای درک یک کلمه جدید در یک کتاب نگاه کند. مولد به تمام کلمات در یک توالی نگاه میکند تا زمینه و روابط بین آنها را درک کند.

مولد از چندین لایه تشکیل شده است که هر کدام دارای چندین زیرلایه هستند. دو زیرلایه اصلی، لایه توجه به خود و لایه پیشخور هستند. لایه توجه به خود، اهمیت هر کلمه در دنباله را محاسبه میکند، در حالی که لایه پیشخور، تبدیلهای غیرخطی را به دادههای ورودی اعمال میکند. این لایهها به مولد کمک میکنند تا روابط بین کلمات در یک دنباله را یاد بگیرد و درک کند.

در طول آموزش، به مولد دادههای ورودی، مانند یک جمله، داده میشود و از او خواسته میشود که بر اساس آن ورودی پیشبینی کند. مدل بر اساس میزان تطابق پیشبینی آن با خروجی واقعی بهروزرسانی میشود. از طریق این فرآیند، مولد یاد میگیرد که زمینه و روابط بین کلمات در یک دنباله را درک کند و آن را به ابزاری قدرتمند برای وظایف پردازش زبان طبیعی مانند ترجمه زبان و تولید متن تبدیل میکند.

نکته ای که باید به خاطر داشت این است که مسائلی در مورد پتانسیل این مدلها برای تولید محتوای مضر یا مغرضانه وجود دارد، زیرا ممکن است الگوها و تعصبات موجود در دادههای آموزشی را یاد بگیرند. شرکتهایی که این مدلها را اجرا میکنند، سعی در ارائه "گارد ریل" دارند، اما خود این گارد ریلها ممکن است باعث ایجاد مشکلاتی شوند. این نگرانیها به این دلیل است که افراد مختلف دیدگاههای متفاوتی دارند. تلاش برای جلوگیری از تعصب بر اساس یک مکتب فکری ممکن است توسط مکتب فکری دیگری به عنوان تعصب تلقی شود. این وضعیت، طراحی یک چتبات جهانی را دشوار میکند، زیرا جامعه پیچیده است.

بیایید ابتدا در مورد دادههایی که به ChatGPT وارد میشوند و سپس در مورد فاز تعامل کاربر در ChatGPT و زبان طبیعی بحث کنیم.

مجموعه دادههای آموزشی ChatGPT

مجموعه دادههایی که برای آموزش ChatGPT استفاده میشود بسیار بزرگ است. ChatGPT بر اساس چیزی به نام مدل زبان بزرگ یا LLM ساخته شده است. بیایید لحظهای به روشن شدن تفاوت چتبات و LLM بپردازیم. یک چتبات اساساً یک برنامه با رابط کاربری است. سوالات یا درخواستها را دریافت میکند، آنها را به یک LLM میدهد و سپس پاسخها را بازیابی میکند، آنها را قالببندی میکند و به کاربر ارائه میدهد. اساساً، یک چتبات یک پوسته رابط کاربری است. این LLM است که خود قابلیت هوش مصنوعی را فراهم میکند.

LLMها در نامها و نسخههای متنوعی عرضه میشوند. در حال حاضر، ChatGPT LLM اصلی GPT-4.0 است. وقتی ChatGPT در اوایل سال 2023 به صحنه آمد، LLM چت جی پی تی 3 بود. برخی از LLMها، مانند OpenAI o3، زمان بیشتری را صرف استدلال میکنند، در حالی که برخی دیگر در تعامل با سبکهای ارتباطی انسانی بهتر هستند. با گذشت زمان، LLMها بهتر میشوند و در نتیجه، خود چتباتها نیز توانمندتر میشوند.

GPT مخففی است که سه حوزه را پوشش میدهد: مولد (G) است، به این معنی که نتایج را تولید میکند؛ از پیش آموزش دیده (P) است، به این معنی که بر اساس تمام دادههایی که دریافت میکند، عمل میکند؛ و از معماری مولد (T) استفاده میکند که ورودیهای متنی را برای درک زمینه وزن میکند.

GPT-3.0 بر روی مجموعه دادهای به نام WebText2 آموزش داده شده است، کتابخانهای با بیش از ۴۵ ترابایت داده متنی. وقتی میتوانید یک هارد دیسک ۱۶ ترابایتی را با قیمتی کمتر از ۳۰۰ دلار خریداری کنید، یک مجموعه داده ۴۵ ترابایتی ممکن است آنقدر بزرگ به نظر نرسد. اما متن فضای ذخیرهسازی بسیار کمتری نسبت به تصاویر یا ویدیو اشغال میکند.

این حجم عظیم دادهها به ChatGPT اجازه داد تا الگوها و روابط بین کلمات و عبارات را در زبان طبیعی در مقیاسی بیسابقه یاد بگیرد، که باعث تولید پاسخهای منسجم و مرتبط با متن سوالات کاربران است.

اگرچه ChatGPT مبتنی بر معماری GPT است، اما بر روی چندین مجموعه داده تنظیم دقیق شده (Fine-Tuned) و برای موارد استفاده مکالمهای بهینه شده است. این فرآیند به آن اجازه میدهد تا تجربهای شخصیتر و جذابتر را برای کاربرانی که از طریق رابط چت با این فناوری تعامل دارند، فراهم کند.

به عنوان مثال، OpenAI (توسعهدهندگان ChatGPT) مجموعه دادهای به نام Persona-Chat منتشر کرده است که به طور خاص برای آموزش مدلهای هوش مصنوعی مکالمهای مانند ChatGPT طراحی شده است. این مجموعه داده شامل بیش از ۱۶۰،۰۰۰ دیالوگ بین دو شرکتکننده انسانی است که به هر شرکتکننده یک شخصیت منحصر به فرد اختصاص داده شده است که پیشینه، علایق و شخصیت او را توصیف میکند. این فرآیند به ChatGPT اجازه میدهد تا یاد بگیرد که چگونه پاسخهایی را تولید کند که متناسب با زمینه خاص مکالمه شخصیسازی شده باشند.

- مجموعه گفتگوهای فیلم کرنل: مجموعهای از دادهها شامل مکالمات بین شخصیتها در فیلمنامههای فیلم. این مجموعه شامل بیش از ۲۰۰۰۰۰ تبادل مکالمه بین بیش از ۱۰۰۰۰ جفت شخصیت فیلم است که موضوعات و ژانرهای متنوعی را پوشش میدهد.

- مجموعه گفتگوی اوبونتو: مجموعهای از گفتگوهای چند نوبتی بین کاربرانی که به دنبال پشتیبانی فنی هستند و تیم پشتیبانی جامعه اوبونتو. این مجموعه شامل بیش از یک میلیون گفتگو است که آن را به یکی از بزرگترین مجموعه دادههای در دسترس عموم برای تحقیق در مورد سیستمهای گفتگو تبدیل میکند.

- DailyDialog: مجموعهای از گفتگوهای انسان با انسان در مورد موضوعات مختلف، از مکالمات زندگی روزمره گرفته تا بحث در مورد مسائل اجتماعی. هر گفتگو در این مجموعه دادهها شامل چندین نوبت است و با مجموعهای از احساسات، عواطف و اطلاعات موضوع برچسبگذاری شده است.

علاوه بر این مجموعه دادهها، ChatGPT بر روی بسیاری از دادههای بدون ساختار موجود در اینترنت، از جمله وبسایتها، کتابها و سایر منابع متنی، آموزش داده شد. این امر به ChatGPT اجازه داد تا در مورد ساختار و الگوهای زبان به معنای کلیتر بیاموزد، که سپس میتواند برای کاربردهای خاص مانند مدیریت گفتگو یا تحلیل احساسات تنظیم شود.

ChatGPT یک مدل متمایز است که با استفاده از رویکردی مشابه سری GPT آموزش دیده است، اما با برخی تفاوتها در معماری و دادههای آموزشی.

به طور کلی، دادههای آموزشی مورد استفاده برای تنظیم دقیق ChatGPT معمولاً محاورهای هستند و به طور خاص برای شامل کردن دیالوگهای بین انسانها تنظیم شدهاند و به ChatGPT اجازه میدهند تا یاد بگیرد که چگونه پاسخهای طبیعی و جذاب را در قالب مکالمه تولید کند.

در اینجا نحوه تفکر در مورد آموزش بدون نظارت ChatGPT آمده است: دادههای زیادی به آن داده شد و به ابزارهای خودش واگذار شد تا الگوها را پیدا کند و همه آنها را درک کند. این مکانیسم به سیستمهای هوش مصنوعی مولد جدید اجازه داد تا به سرعت مقیاسپذیر شوند.

در حالی که فرآیند پیش آموزش، بار سنگین هوش مصنوعی مولد ChatGPT را بر عهده دارد، این فناوری همچنین باید سوالات را درک کند و از دادهها پاسخ بسازد. این بخش توسط مرحله استنتاج انجام میشود که شامل پردازش زبان طبیعی و مدیریت دیالوگ است.

در مورد دخالت انسان در پیشآموزش چطور؟

علیرغم مقیاسپذیری ذاتی پیشآموزش بدون نظارت، شواهدی وجود دارد که نشان میدهد ممکن است کمک انسانی در آمادهسازی ChatGPT برای استفاده عمومی دخیل بوده باشد.

افشاگری بزرگ در مقالهای در مجله TIME بود که در مورد "برچسبگذاران داده" انسانی که بین ۱.۳۲ تا ۲ دلار در ساعت در کنیا درآمد دارند، بحث کرد. طبق گزارش TIME، مسئولیت این کارگران اسکن محتوای اینترنتی وحشتناک و جنسی برای علامتگذاری آن برای آموزش ChatGPT بود.

مقاله دیگری که در Martechpost، یک خبرنامه هوش مصنوعی، منتشر شده است، بیان میکند که مدل زبان بزرگ با استفاده از فرآیندی به نام یادگیری تقویتی از بازخورد انسانی (RLHF) آموزش دیده است: "فرآیند آموزش شامل یک مدل اولیه تنظیمشده با استفاده از یادگیری نظارتشده بود، که در آن مربیان انسانی هم نقش کاربر و هم یک دستیار هوش مصنوعی را بازی میکردند."

در مورد معنای کلمه "آموزش" نکات ظریفی وجود دارد. طبق گفتهی خود ChatGPT، « OpenAI از یادگیری تقویتی با بازخورد انسانی برای آموزش من استفاده نکرد. در عوض، من با استفاده از ترکیبی از تکنیکهای یادگیری بدون نظارت و تحت نظارت، مانند مدلسازی زبان، رمزگذاری خودکار و پیشبینی توالی، از قبل آموزش دیدم. آموزش من شامل پردازش حجم عظیمی از دادههای متنی از اینترنت بود که به من امکان یادگیری الگوها و روابط بین کلمات و عبارات را میداد.»

این هوش مصنوعی ادامه داد: «با این حال، هنگامی که من از قبل آموزش دیدم، محققان و توسعهدهندگان میتوانند از یادگیری تقویتی با بازخورد انسانی برای تنظیم دقیق من برای وظایف یا حوزههای خاص، مانند پاسخ دادن به سؤالات یا تولید متن، استفاده کنند. در این موارد، انسانها میتوانند بازخورد را به صورت پاداش یا جریمه ارائه دهند که میتواند برای بهروزرسانی پارامترهای من و بهبود عملکرد من در وظایف مشابه در آینده استفاده شود.»

به نظر میرسد این پاسخ با گزارشهای Marktechpost و TIME مطابقت دارد، زیرا پیشآموزش اولیه بدون نظارت بود و امکان ورود حجم عظیمی از دادهها به سیستم را فراهم میکرد. اما در ساخت پاسخهای دیالوگ که با کاربران ارتباط برقرار میکنند (بیشتر در ادامه به آن میپردازیم)، ظاهراً موتورهای پاسخ هم در مورد انواع پاسخها و هم برای فیلتر کردن مطالب نامناسب آموزش دیدهاند و به نظر میرسد این آموزش با کمک انسان انجام شده است.

پردازش زبان طبیعی

پردازش زبان طبیعی (NLP) بر توانمندسازی رایانهها برای درک، تفسیر و تولید زبان انسانی تمرکز دارد. با رشد نمایی دادههای دیجیتال و استفاده روزافزون از رابطهای زبان طبیعی، NLP به یک فناوری حیاتی برای بسیاری از کسبوکارها تبدیل شده است.

فناوریهای NLP میتوانند برای بسیاری از برنامهها، از جمله تحلیل احساسات، چتباتها، تشخیص گفتار و ترجمه، مورد استفاده قرار گیرند. با بهرهگیری از NLP، کسبوکارها میتوانند وظایف را خودکارسازی کنند، خدمات مشتری را بهبود بخشند و از بازخورد مشتری و پستهای رسانههای اجتماعی، بینشهای ارزشمندی کسب کنند.

یکی از چالشهای کلیدی در پیادهسازی NLP، مقابله با پیچیدگی و ابهام زبان انسانی است. الگوریتمهای NLP باید روی حجم زیادی از دادهها آموزش ببینند تا الگوها را تشخیص دهند و ظرافتهای زبان را یاد بگیرند. آنها همچنین باید به طور مداوم اصلاح و بهروزرسانی شوند تا با تغییرات در استفاده از زبان و زمینه همگام باشند.

این فناوری با تجزیه ورودیهای زبان، مانند جملات یا پاراگرافها، به اجزای کوچکتر و تجزیه و تحلیل معانی و روابط آنها برای ایجاد بینش یا پاسخ کار میکند. فناوریهای NLP از تکنیکهای متعددی، از جمله مدلسازی آماری، یادگیری ماشین و یادگیری عمیق، برای تشخیص الگوها و یادگیری از حجم زیادی از دادهها برای تفسیر دقیق و تولید زبان استفاده میکنند.

مدیریت گفتگو

شاید متوجه شده باشید که ChatGPT میتواند سوالات تکمیلی بپرسد تا منظور شما را روشن کند یا نیازهای شما را بهتر درک کند و پاسخهای شخصیسازیشدهای را ارائه دهد که کل تاریخچه مکالمه را در نظر میگیرد.

این رویکرد، روشی است که ChatGPT میتواند با کاربران مکالمات چند مرحلهای داشته باشد که طبیعی و جذاب به نظر میرسند. این فرآیند شامل استفاده از الگوریتمها و تکنیکهای یادگیری ماشین برای درک زمینه یک مکالمه و حفظ آن در چندین تبادل با کاربر است.

مدیریت گفتگو جنبه مهمی از پردازش زبان طبیعی است زیرا به برنامههای کامپیوتری اجازه میدهد تا با افراد به گونهای تعامل داشته باشند که بیشتر شبیه یک مکالمه باشد تا یک سری تعاملات یکباره. این رویکرد میتواند به ایجاد اعتماد و تعامل با کاربران کمک کند و منجر به نتایج بهتری برای کاربر و سازمانی که از برنامه استفاده میکند، شود.

نگاهی به درون سختافزاری که ChatGPT را اجرا میکند

مایکروسافت ویدئویی منتشر کرد که در آن نحوه استفاده از Azure برای ایجاد شبکهای برای اجرای تمام محاسبات و ذخیرهسازی مورد نیاز ChatGPT مورد بحث قرار میگیرد. این ویدئو به دلیل بحث در مورد Azure و نحوه معماری هوش مصنوعی در سختافزار واقعی، بسیار جذاب است و در این متن نمی گنجد.

![articleItemsMostView[i].ThumnailImageName](/images/Articles/Thumbnails/4cae76fd106344cfae5ff4ddb16139ca.png)

![articleItemsMostView[i].ThumnailImageName](/images/Articles/Thumbnails/785203d10bad4f8fb87e8c29efefb5df.jpg)

![articleItemsMostView[i].ThumnailImageName](/images/Articles/Thumbnails/d42b325ccf7848d5bb089d6479f9991b.png)

![articleItemsMostView[i].ThumnailImageName](/images/Articles/Thumbnails/f1ffeacc8ad14ae5b6d7deb528036232.jpg)

1 دیدگاه

خیلی جالب بود